Partido de especialistas em IA elege 11 deputados no Japão

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/202611/04/2023

Por redação AIoT Brasil

Uma falha inacreditável ou uma brincadeira de mau gosto? É isso o que a Samsung está tentando descobrir para explicar por que três de seus engenheiros expuseram dados sensíveis da empresa no ChatGPT. E tudo indica que as informações foram recebidas com naturalidade pela inteligência artificial da OpenAI a fim de serem utilizadas como treinamento para futuras respostas públicas, o que aumentou o constrangimento.

O caso foi noticiado inicialmente pelo portal coreano The Economist Korea e em seguida repercutiu mundo afora, pelo seu aspecto inusitado. O vazamento ocorreu 15 dias depois que a Samsung havia autorizado seus funcionários a acessar novamente o ChatGPT, o que estava proibido justamente para evitar esse tipo de problema.

Agora, com os novos incidentes, a fabricante de semicondutores coreana está avaliando a possibilidade de restabelecer a proibição, além de aplicar uma punição disciplinar aos funcionários envolvidos. A política de utilização do ChatGPT é bem clara e alerta que todos os comandos introduzidos no bot podem ser usados para treinamento. A OpenAI também pede aos utilizadores que não coloquem dados sensíveis nos pedidos feitos ao ChatGPT e lembra que a única forma de eliminar informação identificável é apagar a conta, em um processo que pode ser demorado.

De acordo com The Economist Korea, um engenheiro pediu ao ChatGPT para verificar informações sensíveis no código de um banco de dados de semicondutores, para verificar eventuais erros. Outro funcionário o pediu uma otimização de código fonte, em busca de uma “otimização de código”, e um terceiro adicionou a gravação de uma reunião online e solicitou ao bot que gerasse uma minuta. Depois disso, os executivos da Samsung intervieram.

Consta que o uso do ChatGPT para localizar e corrigir erros em códigos tornou-se uma prática comum entre os engenheiros de software. Se os usuários fizerem uma pergunta de codificação, o bot tentará identificar a solução e fornecerá um trecho de código para ser copiado. O Microsoft Bing e o Google Bard também podem detectar bugs em linhas de código, e tudo isso facilita muito o trabalho dos desenvolvedores.

Ao mesmo tempo em que investiga os três engenheiros, a Samsung anunciou que está pensando em construir a sua própria versão do ChatGPT, para evitar que esse tipo de situação se repita. Além disso, a empresa vai limitar o tamanho dos pedidos dos utilizadores a um kilobyte, pouco mais de 1 mil caracteres de texto.

#ChatGPT#dados sensíveis#dados vazados#inteligência artificial#open AI#samsung

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/2026

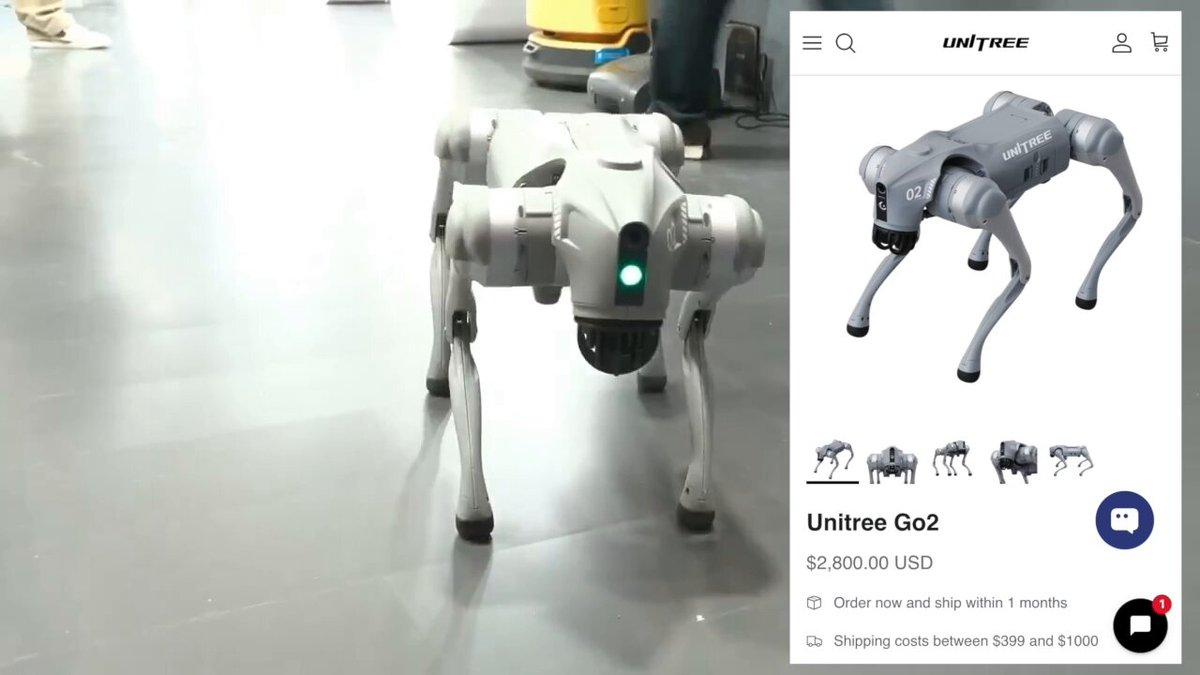

Direção do AI Impact Summit despejou a Galgotias quando uma professora apresentou um cão-robô chinês como se fosse uma invenção própria

23/02/2026

Empresa ampliou a eficiência operacional em processos críticos e a precisão dos dados financeiros

20/02/2026