Partido de especialistas em IA elege 11 deputados no Japão

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/202617/03/2023

Por redação AIoT Brasil

Os rumores que circulavam nas redes se confirmaram e a OpenAI anunciou oficialmente o lançamento da nova versão do ChatGPT, chamada de GPT-4, com mais funcionalidades e as limitações semelhantes aos sistemas anteriores. De acordo com a OpenAI, o GPT-4 é mais avançado e produz respostas “mais seguras e úteis”, podendo resolver problemas difíceis com maior precisão, “graças ao seu conhecimento geral mais amplo e novas habilidades”.

A empresa também afirmou: “O GPT-4 está mais criativo e colaborativo do que nunca. Pode gerar e editar conteúdo e interagir com os usuários em tarefas de redação criativa e técnica, como compor músicas, escrever roteiros ou aprender o estilo de escrita de um usuário”. Disse ainda que a versão 4 supera o ChatGPT em seus recursos avançados de raciocínio e “ao pontuar em percentuais aproximados mais altos entre os participantes dos testes”.

A OpenAI acrescenta: “Seguindo o caminho de pesquisa do GPT, GPT-2 e GPT-3, nossa abordagem de aprendizado profundo aproveita mais dados e mais computação para criar modelos de linguagem cada vez mais sofisticados e capazes”. De fato, algumas das melhorias introduzidas no GPT-4 impressionam, mas a própria OpenAI admite que o sistema ainda apresenta falhas semelhantes àquelas encontradas nos modelos anteriores – ou seja, ainda não atingiu a perfeição.

A empresa passou mais de seis meses no trabalho de alinhamento dos sistemas do novo modelo e no esforço de torná-lo mais seguro. De acordo com dados avançados da pesquisa, a tendência do GPT-4 para responder a questões relacionadas com conteúdo inapropriado foi reduzida em 82%, na comparação com o GPT-3.5. Além disso, a versão tem 40% a mais de probabilidade de gerar respostas factuais.

O novo sistema está disponível no ChatGPT Plus e já há uma lista de espera para usar sua API. O GPT-4 é multimodal, mas, diferentemente do que foi dito anteriormente pela Microsoft, ainda não consegue receber inputs a partir de vídeo, concentrando-se, por enquanto, em imagens e texto. Embora receba inputs com imagens, o modelo continua a gerar resultados textuais. A OpenAI disse que essa funcionalidade está ainda em modo “preview”, para um público restrito.

Nesse sentido, a empresa buscou a colaboração dos criadores do aplicativo Be My Eyes, destinado a pessoas com deficiência visual, a fim de preparar a funcionalidade de interpretação de imagens para o público em geral. Sam Altman, CEO da OpenAI, afirmou também que será necessário mais algum tempo para mitigar os desafios de segurança associados à versão 4.

Team Mirai conseguiu mais de 3 milhões de votos nas eleições deste mês com uma plataforma que defende a ampliação do uso da tecnologia

24/02/2026

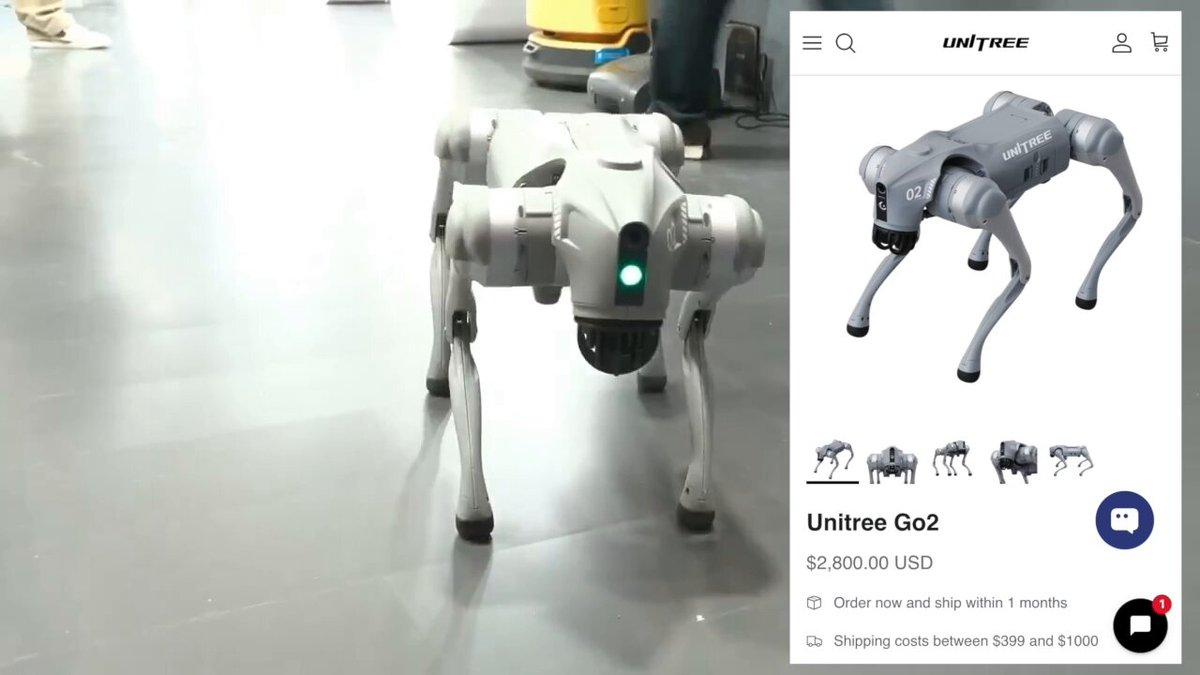

Direção do AI Impact Summit despejou a Galgotias quando uma professora apresentou um cão-robô chinês como se fosse uma invenção própria

23/02/2026

Empresa ampliou a eficiência operacional em processos críticos e a precisão dos dados financeiros

20/02/2026